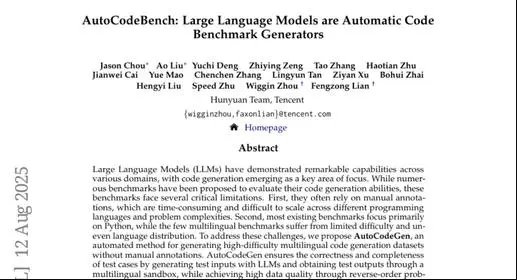

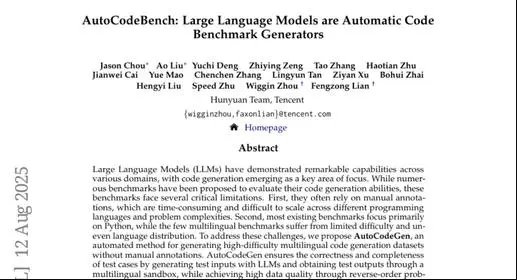

腾讯发布:AI代码评测神器替代人工标注

这项由腾讯混元团队的研究人员Jason Chou、Ao Liu、Yuchi Deng等众多研究者共同完成的研究发表于2025年8月13日,论文题为"AutoCodeBench: Large Language Models are Automatic Code Benchmark Generators"。感兴趣的读者可以通过arxiv.org网站搜索论文编号arXiv:2508.09101v1获取完整研究内容。

现在的AI编程助手越来越厉害,能写出各种复杂的代码。但这里就产生了一个很有意思的问题:我们怎么知道这些AI到底有多厉害呢?就像考试需要试卷一样,测试AI编程能力也需要一套题目。但问题是,现有的编程测试题目大部分都需要专家手工编写,这就像让老师一道题一道题地出考卷,既费时间又费精力。

腾讯混元团队发现了一个巧妙的解决方案:既然AI能写代码,为什么不让AI来出题呢?他们开发了一个名为AutoCodeGen的自动化系统,可以像一个不知疲倦的出题老师,源源不断地生成高质量的编程测试题目。更厉害的是,这个系统不需要任何人工干预,完全自动化运行。

传统的编程测试平台主要集中在Python语言上,而且题目相对简单。腾讯团队的创新在于,他们的系统能够同时处理20种不同的编程语言,从流行的Python、Java到小众的Racket、Elixir都能覆盖。这就像从只会出语文题的老师,变成了能出语文、数学、英语、物理等各科题目的全能老师。

研究团队利用这个系统创建了AutoCodeBench,一个包含3920道编程题目的超大型测试平台。每种编程语言大约有200道题目,分布相当均匀。这些题目不是简单的加减乘除,而是需要AI模型展现真正编程思维的复杂问题。

一、革命性的自动出题机制

传统的编程测试题目制作过程就像手工制作蛋糕,每一道题都需要专家精心设计问题描述、编写标准答案、设计测试用例,然后反复检验确保没有错误。这个过程不仅耗时漫长,而且很难大规模扩展到多种编程语言。

AutoCodeGen系统采用了一种全新的"逆向工程"思路。它不是先想出题目再写答案,而是先从真实的开源代码中提取有价值的代码片段,然后基于这些代码片段来生成对应的编程题目。这就像先有了标准答案,再根据答案来设计考题,确保每道题都有明确可行的解决方案。

整个过程分为四个关键步骤,每一步都像精密机械的齿轮一样环环相扣。首先是代码溶液生成阶段,系统从大型开源代码库Stack-Edu中提取多种编程语言的真实代码片段。这些代码来自GitHub上的实际项目,具有很强的实用性和多样性。系统会对这些代码进行清理和优化,去除冗余部分,保留核心逻辑,确保代码既完整又易于测试。

接下来是测试函数生成阶段,这是整个系统最巧妙的地方。传统方法需要人工设计测试用例,但AutoCodeGen让AI来生成测试输入,然后在多语言沙箱环境中实际运行这些代码,获得准确的输出结果。这就像让厨师按照菜谱做菜,记录下每一步的结果,确保整个流程没有问题。测试分为两类:演示测试包含2-3个基础用例,用于向用户展示函数的基本用法;完整测试包含7个以上用例,覆盖各种边界情况和特殊场景。

第三步是编程问题生成,系统根据已有的代码和测试用例,反向推导出清晰准确的问题描述。这个过程需要遵循严格的规范:必须明确指定编程语言、提供清晰的问题描述、标明函数和类的名称、定义输入输出格式、提供示例用法,但绝不能泄露解决方案的任何线索。

最后是数据过滤阶段,确保生成的题目质量足够高。系统使用中等能力的AI模型过滤掉过于简单的题目,使用高级AI模型作为"评委"检查题目质量,并通过多样性采样确保题目覆盖各种编程场景。这就像有一个严格的质量检查流水线,确保每道题目都达到标准。

二、多语言沙箱环境的技术突破

要让AI自动生成编程测试题目,最大的挑战之一就是如何验证代码的正确性。腾讯团队开发了一个支持20多种编程语言的多语言沙箱环境,这就像建造了一个能够同时处理各种不同"方言"的翻译机器。

这个沙箱环境的设计理念类似于一个高度安全的实验室。每当需要测试一段代码时,系统会在完全隔离的Docker容器中运行代码,确保不会影响主系统的安全。同时配备了防火墙规则,防止恶意代码访问外部网络或系统资源。这种设计既保证了安全性,又能处理大量并发的代码执行请求。

沙箱环境的智能代码整合功能特别值得一提。不同编程语言有着不同的语法规则和运行方式,系统能够自动识别每种语言的特点,将函数代码和测试代码无缝整合。比如Python需要注意缩进,Java需要类声明,JavaScript有特殊的函数调用方式,系统都能自动处理这些细节。

通过Gunicorn多进程架构,这个沙箱环境具备了强大的并发处理能力,可以同时执行数百个代码测试任务。研究团队将这个沙箱环境开源,为整个编程AI研究社区提供了宝贵的工具支持。

三、AutoCodeBench的规模与特色

AutoCodeBench就像一个拥有近4000道题目的超级题库,但它的价值不仅仅在于数量。这个测试平台有几个显著特点,让它在众多编程测试平台中脱颖而出。

首先是语言覆盖的全面性。平台涵盖了20种主流编程语言,从最受欢迎的Python、Java、C++,到相对小众但在特定领域很重要的Racket、Elixir、Julia等。每种语言大约有200道题目,分布相当均匀。这种设计避免了现有平台过分偏重某些语言的问题。

题目难度的分层也很有特色。通过使用中等能力的AI模型DeepSeek-Coder-V2-Lite进行初步筛选,系统能够自动过滤掉过于简单的题目。最终生成的题目中,超过60%被归类为高难度问题。这些题目不是简单的语法练习,而是需要真正编程思维和问题解决能力的挑战。

研究团队还特别关注了多逻辑编程问题的设计。这类题目要求AI模型在一个任务中同时实现多个不同的功能或类,就像要求厨师在一顿饭中同时准备主菜、配菜和甜点。这种设计更贴近实际软件开发中的复杂场景,能够更准确地评估AI的综合编程能力。

为了满足不同用户的需求,团队还推出了AutoCodeBench-Lite简化版本,包含约1600道题目,专门用于快速评估和模型比较。同时还有AutoCodeBench-Complete版本,专门设计用于评估基础模型的代码生成能力,采用少样本学习的评估方式。

四、AI模型的表现令人深思

当AutoCodeBench正式投入使用时,研究团队对30多个主流AI模型进行了全面测试,结果既有惊喜也有意外。这些模型包括了OpenAI的GPT系列、Claude系列、Google的Gemini系列,以及众多开源模型。

令人意外的是,即使是最先进的AI模型在AutoCodeBench上的表现也相当谦逊。最好的模型Claude Opus 4在推理模式下只达到了52.4%的通过率,这意味着将近一半的题目仍然是它无法解决的挑战。这个结果有点像顶尖学生参加高难度考试,虽然表现不错但远未达到完美。

更有趣的发现是推理模式和非推理模式之间的差异。启用推理模式的模型通常比普通模式表现更好,这表明复杂的编程问题确实需要更深层的思考过程。这就像考试时仔细思考和匆忙作答的区别,深思熟虑往往能带来更好的结果。

在不同编程语言上的表现也展现出有趣的模式。大多数AI模型在Python、Java等流行语言上表现相对较好,但在Racket、Shell、Elixir等小众语言上就显得力不从心。这种差异反映了训练数据的不平衡性,主流语言的代码样本更多,模型自然学得更好。

多逻辑编程问题对所有模型都构成了特殊挑战。当题目要求同时实现多个相关功能时,模型的表现普遍下降3-5个百分点。这说明当前的AI模型虽然能处理单一功能的编程任务,但在处理复杂的多模块协调方面还有很大提升空间。

五、测试中的意外发现

研究过程中的一些发现让人对AI编程能力有了更深的认识。当研究团队让AI模型进行多轮代码修正时,发现了一个有趣现象:给模型提供沙箱执行的错误信息后,它们能够显著提升代码质量。

DeepSeek-V3-0324模型通过三轮迭代修正,成功率从48.1%提升到59.7%,这个提升幅度相当可观。这就像学生做错题后看到错误提示,能够逐步改进答案。这个发现说明AI模型具备了一定的调试和错误修正能力,这对实际编程应用具有重要意义。

在参数规模与性能的关系研究中,团队发现了一个有意思的规律:推理模式对大模型的帮助更明显。Qwen3系列模型在启用思维链推理后,性能提升曲线特别陡峭,说明复杂推理能力确实随着模型规模增长而加强。

测试时采样策略的研究也很有价值。当给模型多次尝试机会时,所有模型的表现都有一致的改善,但改善速度趋于稳定。这表明简单的重复尝试能够一定程度上提升成功率,但效果有限,真正的突破还需要算法本身的改进。

研究团队还发现了模型能力的互补性。虽然单个模型的最高成功率只有52.4%,但如果将所有模型的正确答案联合起来,理论上限可以达到74.8%。这说明不同模型在处理不同类型问题时各有所长,未来可能需要集成多种模型来达到更好的效果。

六、质量验证与偏差分析

为了确保AutoCodeBench的质量,研究团队进行了严格的人工验证。他们邀请6位专业程序员对生成的题目进行检查,重点关注测试函数是否正确、是否与问题描述一致、是否存在逻辑错误等关键问题。

验证结果显示,AutoCodeBench达到了87.6%的准确率,这个数字在自动生成的编程测试中已经相当不错。但研究团队并没有因此而满足,他们诚实地分析了系统可能存在的偏差问题。

由于整个生成过程主要使用DeepSeek系列模型,可能会对这个模型家族产生有利偏差。研究团队通过多阶段分析发现,这种偏差确实存在但影响有限。有趣的是,在某些阶段,其他模型家族反而获得了更大的性能提升,说明偏差问题比预想的复杂。

为了减轻偏差影响,系统设计了"推拉平衡"机制:在简单问题过滤阶段使用较弱的DeepSeek模型创造不利条件,在质量评估阶段使用强模型,这种设计在一定程度上平衡了可能的偏差。

研究团队还发现,最常见的问题不是逻辑错误,而是问题描述不够完整。有些测试函数引用了在问题描述中没有明确提及的类名或函数名,或者对边界情况的处理要求不够明确。这个发现很有价值,因为它指出了自动生成编程题目时需要特别注意的关键点。

七、对AI编程未来的启示

AutoCodeBench的出现不仅仅是一个测试工具,更像是给AI编程领域照了一面镜子。从测试结果可以看出,当前最先进的AI模型在面对真正复杂的编程挑战时仍有很大改进空间。

测试揭示的语言不平衡问题特别值得关注。主流编程语言和小众语言之间的巨大性能差距,反映了AI训练数据和关注重点的不均衡。未来的AI编程系统需要更好地支持多样化的编程语言,特别是在特定领域有重要应用的小众语言。

多逻辑编程能力的不足暴露了另一个重要问题。实际软件开发往往需要协调多个模块、处理复杂的依赖关系,这正是当前AI模型的薄弱环节。这提示我们,单纯提升单一功能的编程能力是不够的,需要更多关注系统性的编程思维。

AutoCodeGen方法本身也具有重要的扩展价值。这种"代码先行、问题反推"的思路不仅可以用于生成测试题目,还可以用于创建高质量的训练数据。研究团队指出,同样的技术流程稍加修改就可以为AI模型训练提供大量高质量的代码-问题对。

沙箱环境的开源更是为整个研究社区提供了宝贵资源。其他研究团队可以在此基础上开发自己的评估工具,或者扩展到更多编程语言和应用场景。这种开放共享的理念有助于推动整个AI编程领域的快速发展。

说到底,AutoCodeBench的真正价值在于为AI编程研究提供了一个更加全面、严格的评估标准。就像高考为教育质量提供了统一衡量标准一样,这个平台可能会成为AI编程能力评估的重要基准。当然,任何单一的测试都有其局限性,但AutoCodeBench在多语言支持、题目多样性、自动化生成等方面的创新,确实为这个领域带来了新的可能性。

这项研究也提醒我们,AI编程助手虽然已经很有用,但离真正替代程序员还有相当距离。目前的AI更适合作为编程伙伴而非替代者,在人类程序员的指导下处理具体的编码任务。随着像AutoCodeBench这样的评估工具不断完善,我们对AI编程能力的认识会越来越准确,这对于合理设定期望、指导技术发展都有重要意义。

Q&A

Q1:AutoCodeGen系统是如何自动生成编程题目的?

A:AutoCodeGen采用了独特的"逆向工程"方法。它先从真实的开源代码中提取有价值的代码片段,然后让AI生成测试输入,在多语言沙箱中运行获得准确输出,最后根据代码和测试结果反推生成问题描述。这就像先有标准答案再出考题,确保每道题都有可行的解决方案。

Q2:AutoCodeBench与现有编程测试平台有什么优势?

A:AutoCodeBench支持20种编程语言的均匀分布,而现有平台多数只专注Python等少数语言。它包含3920道高难度题目,超过60%为复杂问题,还特别设计了多逻辑编程挑战。最重要的是完全自动化生成,无需人工标注,大大提升了扩展效率。

Q3:目前最强的AI模型在AutoCodeBench上表现如何?

A:即使是最先进的Claude Opus 4也只达到52.4%的通过率,说明当前AI编程能力还有很大提升空间。模型在主流语言上表现较好,但在小众语言和多逻辑编程问题上明显吃力。不过启用推理模式能显著提升性能,多轮迭代修正也很有效。

时间:2025-08-16 13:29 来源:未知 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关推荐:

网友评论: